- Gedanken hörbar machen

- Test mit Epilepsie-Patientin

- International Phonetic Alphabet

- Siri als Blindenhund

Siri und Google Assistant machen es seit Jahren vor: Die beiden populärsten IPA – Interactive Personal Assistants – geben ihrem Nutzer Auskunft über all das, was ihn bewegt. Im Auto läuft ein Teil dessen über die Carplay-Schnittstelle oder Android Auto. Während die automobile Industrie langsam, aber sicher einsieht, dass es besser ist, diese Systeme zu verwenden, forschen Bremer Wissenschaftler daran, ihnen Mehrwert zu geben. Eine Neuroprothese soll Stumme sprechen, Taube hören und vielleicht gar Blinde sehen lassen.

Den Kopf leicht zur Seite gedreht, von seiner Krankheit gezeichnete, schelmisch gespitzte Lippen, ein stets offener Blick: So haben die allermeisten den 2018 im britischen Cambridge verstorbenen Astrophysiker Stephen Hawking in Erinnerung. Aufgrund der Nervenkrankheit ALS an den Rollstuhl gebunden, teilte sich Hawking per Sprachcomputer mit. Eigenständig zu reden, das war ihm 33 Jahre lang unmöglich. Stets in sich ruhend, reichte ihm in seinen letzten Jahren jedoch allein das Zucken seines Wangenmuskels, um sich verständlich zu machen.

Gedanken hörbar machen

Hawkings Supercomputer hat viele Nachahmer gefunden. Auf dem Massenmarkt geben Apples Siri und Googles Assistant einen Einblick in das, was möglich ist – solange man es fachgerecht nutzt. Die Schnittstellen, an denen neue Technologien andocken können, sind damit für Drittanbieter geöffnet. Zu denen zählt nun auch die Universität Bremen.

Der Sprachcomputer des britischen Physikers Stephen Hawking hat viele Nachahmer gefunden.

Eine Neurosprachprothese des Cognitive Systems Lab, kurz CSL, soll die Lebensqualität der Menschen, die wie Hawking an neuromuskulären Krankheiten leiden, verbessern. „Unser System zielt darauf ab, ihnen natürliche Gespräche zu ermöglichen“, sagt Tanja Schultz, Professorin für Informatik und Leiterin des CSL. Der erste große Schritt sei vollbracht. Die Versuchspersonen hörten sich reden, obgleich sie sich das Gespräch lediglich vorstellten. Die Prothese sei in der Lage, im Kopf vorgestellte Wörter hörbar zu machen.

Für die Automobilindustrie ist eine Technik wie diese langfristig goldwert – das alte Schlagwort: autonomes Fahren. Wer Gedanken akustisch erlebbar machen kann, kann sie auch lesen. Wer sie lesen kann, kann sie auf sämtlichen Kanälen ausspielen. Entscheidet sich der Fahrer zum Beispiel kurzerhand für ein anderes als das in der Navigation eingegebene Ziel, erfüllt das Auto den Wunsch – vollkommen wortlos.

Test mit Epilepsie-Patientin

Der Autor der Bremer Studie ist Miguel Angrick. Für seine Doktorarbeit hat der mittlerweile promovierte 30-Jährige den dazugehörigen Algorithmus entwickelt. Eine Epilepsie-Patientin stellte sich für die Versuchszwecke zur Verfügung. Mittels in ihr Gehirn implantierter Tiefenelektroden erforschten die Wissenschaftler die Zusammenhänge von physischer Hirnaktivität, emotionaler Äußerung und sprachlicher Umsetzung. „Wenn Menschen sprechen, kommt der Impuls dafür aus dem Gehirn“, erläutert Angrick. „Mit implantierten Elektroden können wir diese Prozesse darstellen, indem wir die entsprechenden Gehirnströme aufzeichnen.“

Bis dato "reden" Stumme und "hören" Taube insbesondere mittels Gebärdensprache.

In einem weiteren Test lasen mehr als 20 Teilnehmer einen ausgewählten Text laut vor. Die Mitglieder des Projektteams, an dem auch die Commonwealth Universität in Virginia (USA) und die Universität Maastricht (Niederlande) beteiligt sind, zeichneten währenddessen die Sprache und die zugrunde liegenden Hirnströme auf. Beides kombiniert, lässt sich feststellen, welche neuronale Aktivität mit welchem Laut verbunden ist.

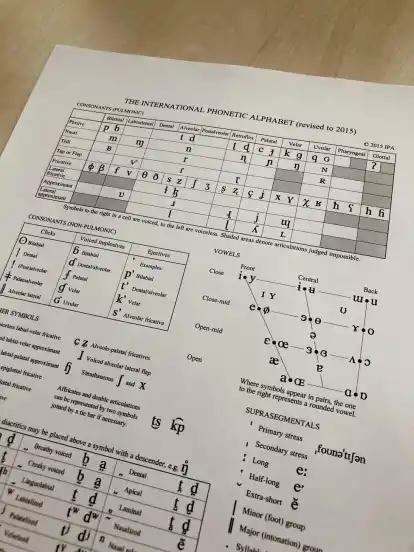

International Phonetic Alphabet

Ein Werkzeug dazu ist das zuletzt 2015 aktualisierte International Phonetic Alphabet der International Phonetic Association. Das Ziel sei es, Studien der Lautlehre samt all ihrer Anwendungen zu unterstützen, heißt es auf der Website der Gesellschaft – das gilt vom Sprechertraining bis zur Programmierung von Sprachassistenten.

IPA ist mehr als der Interactive Personal Assistant. Unter derselben Abkürzung firmiert das International PhoneticAlphabet.

Eine Gedankenlesemaschine sei keinesfalls das Ziel der Bremer Forscher. Die Prothese soll lediglich das hörbar machen, was Patienten aussprechen möchten. „Wenn flüchtige Gedanken durchs Hirn sausen, gehen wir nicht davon aus, dass das geplant und artikuliert wird “, sagt Schultz. „Das wollen wir auch gar nicht“, fügt Angrick hinzu.

Siri als Blindenhund

So heißt die bedeutendeste Herausforderung einmal mehr Datenschutz. Vor allem jedoch geht es um das Prinzip des selbstbestimmten Ichs. Technisch gesehen filtert das System dazu den bewusst gefassten Gedanken von den durch äußere Einwirkungen ausgelösten Reaktionen von Körper und Geist.

Siri als Stadtführerin und Blindenhund? Alles denkbar.

Noch befindet sich die Bremer Technologie im Aufbau. Stummen eine Stimme zu geben, Taube eine solche hören lassen – das könnte jedoch gar die Gebärdensprache ablösen. Mittels Sprach- und Hörcomputer. An die Clouds und die Bordelektronik eines Autos gekoppelt, könnte die Technologie zudem die Fußgängererkennung auf ein neues Level hieven. Sämtliche Störgeräusche ausgeblendet, ließe sich gar ein Blinder durch die Stadt führen. Siri als Stadtführerin – oder virtueller Blindenhund.